Wer sich ein neues, technisches Gerät kaufen will, unterzieht normalerweise die Datenblätter oder zumindest die Produktbewertungen einer genauen Prüfung. Entspricht das Gerät meinen Wünschen und erfüllt es den Zweck der Anschaffung? Geräte im täglichen Gebrauch werden jedoch im Allgemeinen immer kleiner und intelligenter. Dies hat den Nebeneffekt, dass fast überall Datenspeicher verbaut werden. Sei es im klassischem Sinne im PC, Laptop, Tablett, Smartphone, Server, Spielekonsolen oder auch in Geräten, welchen man im ersten Moment nicht ansieht, dass es sich um Maschinen zur Datenverarbeitung handelt. Dabei fällt man mit größter Wahrscheinlichkeit über Begrifflichkeiten und Abkürzungen, wie SSD, M.2, U.2, SATA, NVMe, HDD, HHD, usw., welche die hervorragenden Eigenschaften der Datenspeicher bewerben sollen.

Wir wollen an dieser Stelle ein kleines Einmaleins zu den größeren Datenspeichern und deren Anschlusstechnik beleuchten. Des Weiteren soll die Entstehung in einer zeitlichen Abfolge nachvollziehbar sein. Die USB-Stick-Technik, Speicherkarten (SD), optische Medien (CD, DVD, Blu-ray) und fest aufgelötete Speicher sind hierbei ausgenommen. Los geht’s:

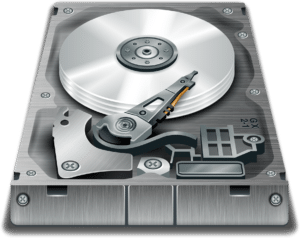

Vom Großvater… HDD:

Seit es Computer gibt, gibt es auch Datenspeicher. Der Weg der notwendigen Sicherung von Programmabläufen und deren Ergebnissen war lang und verlief über vielerlei Technikarten. Wer erinnert sich noch an Lochkarten auf Papier? Vor- und Nachteile ließen die eine Technik sterben und die effektivere fortbestehen. Relativ bald etablierten sich jedoch die Datenspeicher auf Magnetfeldbasis und konnten sich lange halten. Manche werden jetzt sofort an die Festplatte denken, oder auch „Hard Disk Drive„, kurz HDD.

Das ist auch korrekt, aber bitte den Vorgänger, die Diskette, oder die Speicherbänder und Kompaktkassetten für Kassettenrecorder nicht vergessen. Bei dieser Art der Datenspeicher werden rotierende Scheiben oder magnetisierbare Bänder mit einem Schreib- und Lesekopf abgetastet und durch erzeugte Magnetfelder (Induktion) ausgelesen. Im Falle der heutigen Festplatten ist die Technik sehr weit ausgereift und bietet viel Speicherplatz für wenig Geld. Die Technik hat jedoch, unter anderem, einen entscheidenden Nachteil: Die Mechanik. Naturgesetze können nicht ausgehebelt werden und diese besagen, je schneller sich etwas bewegt, desto mehr Reibung entsteht und Massen verhalten sich träge bei Beschleunigungs- und Abbremsvorgängen. Heißt, Festplatten haben eine natürliche Grenze, was Datentransferraten und Zugriffszeiten anbelangt. Auch sind Einsatzgebiete mit häufigen Erschütterungen kontraproduktiv und reduzieren die Lebensdauer erheblich. Gebaut wurden die HDDs überwiegend im 3,5″-Format (sprich „3,5 Zoll“) und 2,5″ für Laptops und Geräten mit wenig Platzangebot.

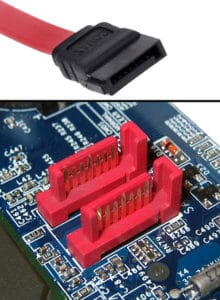

Kommen wir zu der heute gebräuchlichsten Schnittstelle für HDD: „Serial AT Attachment„, kurz SATA

Bussysteme, also vereinfacht ausgedrückt, Datenübertragungen von einem Sendegerät zu dem Empfängergerät über nur eine Kupferverbindung (und Masse) waren zwar zur Einführung von SATA keine neue Technik mehr, jedoch setzte sich diese Schnittstelle im privaten Bereich durch. Die Vorgängerkabel von SATA erreichten, aufgrund mangelnder Übertragungsgeschwindigkeit der Schnittstellenkontroller, ihre Datenraten nur über mehrere, parallel verlegte Kabel. Wisst ihr noch, wie diese Schnittstelle genannt wurden? Schreibt es in den Kommentaren.

SATA hatte die Vorteile, dass mehr Daten übertragen werden konnten, bis zu 6,0 Gbit/s, und die Geräte theoretische einen Austausch während des Betriebes zuließen. Zudem konnten die Kabel besser im Geräteinneren verlegt und versteckt werden, was optisch neue Möglichkeiten bot und den Kühlkonzepten nicht im Wege stand. Zudem wurden kleine Zwischenspeicher und „Warteschlangen“ eingeführt, welche die Datenübertragung optimierten (Advanced Host Controller Interface – AHCI).

Über den Vater… HHD & SATA-SSD:

Die vorgenannten Zwischenspeicher, auch „Cache“ genannt, bestanden aus „Festspeicher“. Dies besagt, dass diese Technik aus elektronischen Bauteilen, wie z.B. Transistoren, aufgebaut sind. Cache benötigte innerhalb von Prozessoren und Controllern aber immer relativ viel Platz und war im Vergleich zu dem geringen Speicherplatz sehr teuer. Es gibt Techniken für flüchtigen (sobald Strom abgeschaltet wird, sind die Daten gelöscht) und nicht flüchtigen Speicher (Daten bleiben auch ohne Strom erhalten, jedoch langsame Schreibrate und Lebensdauer durch Schreibzugriffe begrenzt). Die Optimierung und Weiterentwicklung dieser Speicher ergeben grob gesprochen, die heutigen RAM-Speicher (flüchtig) und die „Solid State Drive„, kurz SSD.

Bei dem nicht flüchtigen Speicher sahen einige Hersteller den Vorteil, dass diese keine mechanischen Grenzen aufwiesen und so zunächst eine Nische für Datenspeicher im Markt bilden konnten. Eine reine Hochskalierung (Aneinanderreihung der vorhandenen Speicherzellen) war jedoch aus Platzgründen nicht möglich. Die Technik benötigte eine grundlegende Überarbeitung. Damit die Kunden jedoch die Vorteile der neuen Technik erfahren konnten, wurden die „Hybridfestplatten“, kurz HHD, entwickelt. Es handelt sich hierbei um herkömmliche Festplatten mit aufgeblasenem, nicht flüchtigen Zwischenspeicher. Dies bewirkte eine wesentlich verringerte Reaktionszeit und für kleinere, oft benutzte Daten eine Erhöhung der Datentransferrate. Welche Daten im Zwischenspeicher abgelegt wurden, bestimmte das Betriebssystem und nicht der verbaute Controller. Es handelte sich also eigentlich um eine Softwarelösung. Benutzt wurden weiterhin der SATA-Standard, jedoch wurde dieser hier bereits zusehends zum Flaschenhals.

Ziemlich bald nach den HHDs kamen bezahlbare, aber auf SATA-basierende, SSDs im 2,5″-Format. Diese sprengten schnell die Grenzen des SATA-Anschlusses. Auch war es möglich, mithilfe von Software von Intel aus einer SATA-SSD und einer HDD einen Verbund (RAID) zu bilden und so eine HHD nachzubilden.

Parallel wurde innerhalb des PCs die Übertragungsart von Prozessor (CPU), Grafikkarte (GPU) und weiteren Controllern auf dem Mainboard, z.B. die USB-Anbindung und Soundkarte, von den Bussystemen „AGP“ und „PCI“ zu „PCI Express“ weiterentwickelt und ausgeweitet. „Peripheral Component Interconnect Express“, kurz PCIe oder PCI-E.

Zu dem Sohn… m.2-SSD:

Da es absehbar war, dass SATA seine Grenzen erreicht hat, wurde nach Alternativen für Massenspeicher gesucht. Hierbei bot sich der schnelle und flexible PCI-E an, welcher bereits auf jedem Computersystem verwendet wird. Ein erster Standard, welcher eine Art Zwitter zwischen SATA-Steckverbindung aber mit PCI-E-Anbindung bildete, war „SATA Express“ oder auch SATAe. Dieser bot jedoch keine weiteren Vorteile, wie kompaktere Bauweise in kleinen Geräten zu seinem Vorgänger und enthielt nur maximal „2-Lanes“ des PCI-E. Jede Lane bildet hierbei einen eigenen Bus. Je höher die Anzahl der angebundenen Lanes, desto höhere Datenraten sind theoretisch möglich.

SATAe setzte sich jedoch nicht durch. Stattdessen kam NVMe mit M.2-Steckplatz bzw. U.2-Steckverbindung:

„NonVolatile Memory Express„, kurz NVMe ist eine standardisierte Schnittstelle, um SSDs optimal über PCI-E zu verbinden. Die Bezeichnung NVM steht hierbei für den englischen Begriff für „nichtflüchtige Massenspeicher“. Im Idealfall sieht der Standard vor, dass keine herstellerspezifische Treiber nötig sind.

Aufbauend auf NVMe wurde der M.2-Steckplatz und die U.2-Steckverbindung entwickelt. U.2 ist im Prinzip gleich, wie der M.2, es handelt sich hierbei jedoch um eine Steckverbindung. Ein gleichzeitiger Betrieb von M.2 und U.2 sind in der Regel nicht möglich. Pro M.2-Steckplatz sind bis zu vier PCI-Express-Lanes (32 GBit/s), ein SATA (6 Gbit/s) und/oder ein USB 3.0 Port nutzbar. Unterschieden werden die verwendbaren und zu verwendenden Bussysteme durch sogenannte „Keys“. Diese stellen Aussparungen bei den Pins der Modulkarte dar. Bei dem Bild mit der NVMe-SSD sieht man rechts unten z.B. die „Key M“-Codierung, welche gleichzeitig die derzeit höchste Übertragungsrate für SSDs darstellt.

In einen M.2-Steckplatz können sehr kompakte, rechteckige Karten in unterschiedlichen Abmessungen eingesetzt werden. Das Format ist für mobile Geräte oder Mini-PCs optimal geeignet. Es muss jedoch auf Hitzestaus geachtet werden, welche die effektiv nutzbare Leistung erheblich einschränken kann. Diese universell nutzbare Schnittstelle kann natürlich auch für WLAN, Bluetooth, GPS, NFC oder weitere Module verwendet werden. Vorteil des M.2 ist, dass die Kommunikation auf dem Bus verschlankt und für parallelen Zugriff optimiert wurde. Dies kommt Anwendungen mit Multithreading-Technik zu gute. Befestigt werden die Modulkarten mit einer Arretierschraube (siehe Bild NVMe SSD, Aussparung links).

Aufgepasst werden muss, dass eine PCI-E-Lane eine direkte Verbindung zur CPU darstellt. Jedoch nicht jede CPU kann alle möglichen PCI-E-Verbindungen auf dem Mainboard gleichzeitig bedienen. Heißt, will man für seine SSD die maximal mögliche Übertragungsrate über M.2 nutzen, muss man das Handbuch des Mainboards genau lesen und feststellen, welche PCI-E-Lane „geteilt“ ist. So kann es z.B. sein, dass der M.2-Steckplatz seine PCI-E-Verbindung mit einem USB-Controller teilt. Hier kann es dann sein, dass nicht beides gleichzeitig genutzt werden kann.

Nennt ihr bereits eine NVMe-SSD euer eigen? Wie sind eure Erfahrungen?

„Die Vorgängerkabel von SATA” waren das nicht die IDE-Kabel?

Ja, das waren IDE Kabel 😅 Mein Gott, wie sterrisch die waren 😅

Haha, stimmt. Es war eine wahre Herausforderung die Flachbandkabel einigermaßen ansehnlich zu verlegen. Ich hatte die IDE-Kabel auch in einem PC in runder Form. Die waren durch den großen Querschnitt noch schlimmer zu verlegen.

Ja, vor SATA gab es IDE. Mein erster PC hatte sogar noch ein oder 2 Slots für den IDE-Vorgänger, ich glaube das war ISA. ^^ Und irgendwo hier fliegen noch alte Festplatten und Kabel für IDE herum.

Den Notfall-Ersatz-PC werde ich wohl doch nicht mehr zusammen basteln. XD

ISA war der Vorgänger von PCI.

IDE gab es sehr lange.. am anfang mit den PIO-Modes (1-4 meine ich) der später durch UDMA (wenn ich mich recht erinnere, 33, 66, 100 und 133) ersetz wurde da PIO immer über die CPU lief (IRQ)

IDE (Integrated Drive Electronics) ist korrekt.

Ergänzend: Zu späteren Zeiten als SATA (serielle Übertragung) vor der Tür stand, wurde auch der Begriff „PATA“ verwendet. Dies sollte der Verdeutlichung dienen, dass es sich um eine parallele Datenübertragung handelt.

Danke für die Auflistung.

Gerade in Bezug auf M.2 liest man in Kundenbewertungen wahre „Wunderdinge“!?

Sind für alles Top bis auf die Hitze entwicklung und natürlich Archive sind Flash Speicher nicht gedacht.

Aber Speed, zuverlässigkeit, Grösse und natürlich strom sind sie unschlagbar. Natürlich auch im (noch)Preis 😛

Hab jetzt seit 2 Monaten den m.2 anschluss in gebrauch. Im gegensatz zu meiner normalen ssd merke ich in der täglichen anwendung nicht wirklich einen unterschied, außer dass der windows bootvorgang nochmal ein paar Sekunden schneller geworden ist.

Habe von der 850 Evo auf die 960 Evo gewechselt und für mein empfinden geht das Booten, Entpacken und start von paar programmen spürbar schneller.

In der 8bit-Ära wurden App’s zum Abtippen in Zeitschriften abgedruckt. Das waren 4-6ZeichenfolgeReihen auf einige Seiten verteilt. Sowas wie Base64. Aus dem wurde binär generiert. Leute ohne Speichermedium haben das öfter – also quasi vor Anwendungsstart gemacht! 😊 Im Bayerischen Rundfunk wurde zur Sendung im Radio Code ausgestrahlt, dieser wurde auf Kassette aufgenommen und in Datasette eingespielt.

Nennenswert ist auch das legendäre ZIP-Laufwerk!

SAS wurde vergessen !!!

Fehlt noch SCSI 😉

Leider vergessene Technik die Seinerzeit TOP aber zu teuer für die meisten war… ( SCSI Karte, 2 Brenner und eine HDD dran… 2 Sachen gleichzeitig brennen genial)

und der U-SCSI mit 68Pin

Zur Frage in den Artikel.

Master und Slave

Und nicht vergessen den Jumper richtig setzen.

Wieder ein toller Artikel….Applaus.

(E)IDE ihr lieben Waren die Vorläufer von S-ATA

Korrekt 👍

Vor IDE war MFM aktuell, mit 5.25″ Festplatten mit 20MB Speicher, brauchte einen speziellen Kontroller

Wo genau ist hier Intel Optane einzuordnen?